為了提升服務質素,我們會使用 Cookie 或其他類似技術來改善使用者的閱讀體驗。 如想了解更多請到 這裡 >。

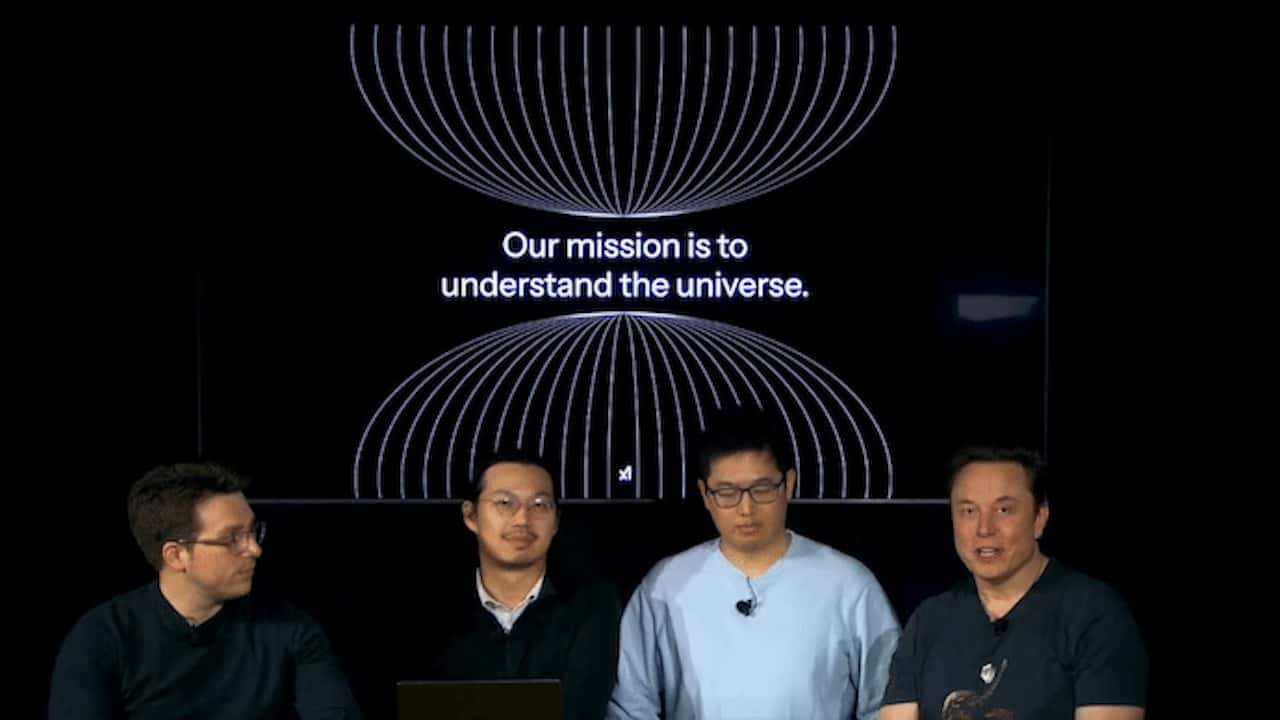

馬斯克透露,Grok-3 訓練過程共動用了 20 萬塊 NVIDIA GPU,並在 xAI 自家數據中心 完成。有技術人員表示:「我們花了 122 天 才完成前 10 萬張 GPU 訓練,但這只是開始。如果要打造真正的超級 AI,我們需要將算力規模再翻倍。」

相比之下,DeepSeek-V3 以 OpenAI 1/20 的成本 訓練出了 R1 模型,而 Grok-3 的資源消耗卻高達 DeepSeek-V3 的 263 倍,讓業界震驚。有專家認為,當全球 AI 企業逐步轉向低成本解決方案,Grok-3 的昂貴訓練開支與未來未開源的策略,恐將影響其市場普及度。